Publicado originalmente no Macmagazine: https://macmagazine.com.br/post/2023/12/02/tamanho-importa-e-quanto-menor-melhor-a-ciencia-e-a-tecnologia-por-tras-dos-3-nanometros/

Algumas semanas atrás, a Apple anunciou a família M3 do seu Apple silicon, em um horário pra lá de estranho, nas vésperas do feriado de Halloween. E lamentavelmente, nenhum dos apresentadores veio fantasiado para o evento! Uma enorme mancada do pessoal de marketing da Apple. Um Tim Cook com capa e dentadura de vampiro era o mínimo esperado para um evento como esse! Ficou pra próxima oportunidade. Dentre os lançamentos nada de muito especial. Imacs e MacBooks equipados com o novo microchip M3, uma belíssima “nova” (Blackbook 2006 mandou lembranças!) cor preta para os MacBooks Pro de 16”. E mais uma vez, vários daqueles gráficos sem sentido de comparação de performance entre os microchips M3 e os demais do mercado, onde não se explica direito o que foi medido nem como foi medido. Algo que pode entusiasmar os fãs mais apaixonados, mas que tecnicamente não significa nada e não traz informação alguma. Sem dúvida, o maior acontecimento da noite, a grande novidade, foi a chegada da tecnologia de 3 nanômetros na fabricação dos microchips da família M3. Esse sim é um assunto que merece uma discussão um pouco mais profunda e detalhada.

A família M3 da Apple e algumas de suas especificações técnicas. Fonte: Apple

O meu é menor que o seu, e isso é ótimo!

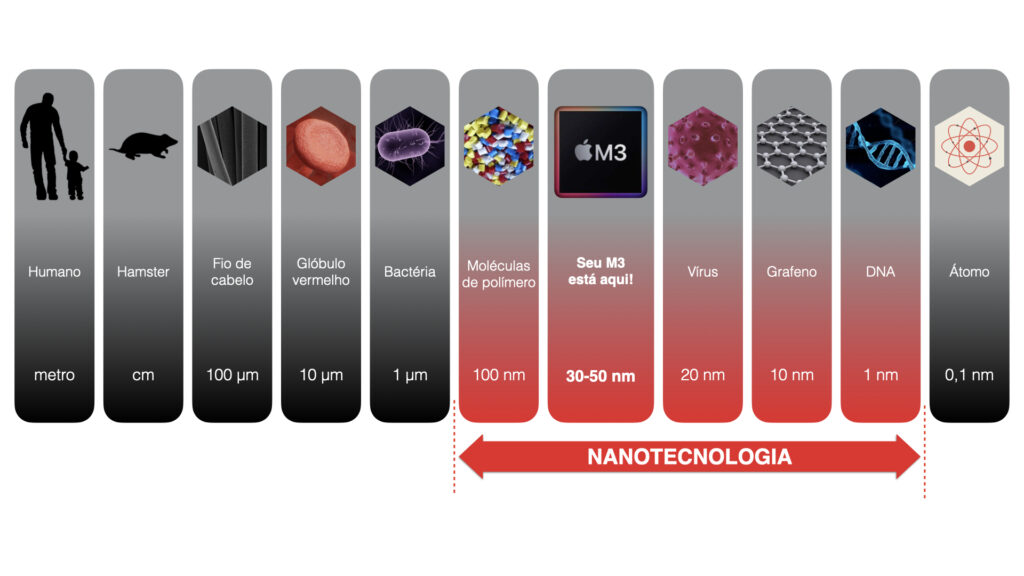

Infelizmente, preciso começar a conversa trazendo más notícias: não há nada “fisicamente” fabricado com dimensão de 3 nanômetros no microchip M3. Assim como não há nada de 5 nm no M1 Pro do MacBook que estou escrevendo agora, ou de 32 nm no i3 do meu iMac 2010 de casa. Essa nomenclatura é apenas uma estratégia de marketing adotada no Roadmap Internacional para Dispositivos e Sistemas (IRDS), espécie de consórcio internacional que “prevê” o futuro das técnicas de micro (nano?) fabricação. Até meados dos anos 80-90, a nomenclatura dos microchips mantinha relação direta com o tamanho físico dos transistores dentro do processador. A partir dos anos 90, com o avanço nas técnicas de fabricação e o aumento na complexidade dos microchips, essa relação deixou de fazer sentido. Os fabricantes começaram a usar esses números apenas para mostrar o quanto seu processador atual era “melhor” que o da geração anterior. Assim, cria-se a ilusão de que um microchip de 3 nm é duas vezes “melhor” que um microchip de 6 nm. Reparem como é algo subjetivo. O que é “duas vezes melhor”? É algo que tecnicamente não significa muita coisa, mas que pode ter um enorme apelo em termos de marketing. É algo do tipo “o meu é menor que o seu”, e do ponto de vista de computação isso é excelente, já que passa uma ideia de maior densificação, de grande quantidade de transistores, de potência e desempenho. Recentemente, os fabricantes tem abandonado essa nomenclatura baseada em “nanômetros”. A própria TSMC se refere a seus microchips como “TSMC N3” e não “TSMC 3 nm”. A Intel fala simplesmente em “Intel 3”. Na prática, as dimensões dos transistores nas últimas gerações de microchips são da ordem de 10x o número anunciado. Nos microchips M3, estamos falando de componentes de 30-50 nanômetros. (Disclaimer: eu estou simplificando bastante aqui, falando em “componentes”. Não faz sentido, em um texto como esse, entrar em detalhes como tamanho de gate, metal pitch ou gate pitch. Se você é um especialista em técnicas de microfabricação, entenda que este é um texto pra quem não é especialista na área!).

Em resumo, mesmo sabendo que o termo “3 nm” é mais uma jogada de marketing que qualquer outra coisa, você quer se “gabar” dos 3 nm no seu iPhone 15 Pro ou no seu novo Mac certo? Você já deve ter repetido várias vezes, com cara de espanto, a afirmação de que “a Apple comprou toda a produção de microchips de 3 nm da TSMC”! Mas fala pra mim, diz a verdade, você sabe o que são 3 nm? Você tem ideia do que é 1 nanômetro? O que significa esse prefixo “nano”? Sabe porque o processo de produção de 3 nm é tão importante e relevante para o futuro da industria de semicondutores? Não? Então vem comigo!

Nanotecnologia

Originalmente, “nano” é uma palavra do Grego antigo que significa “anão”. No Sistema Internacional de Unidades é adotado como prefixo que significa a bilionésima parte de uma unidade. 1 nanômetro (1 nm), é a distância de 1 metro dividido por 1 bilhão, ou, 0,000000001 m (ou ainda 10-9 m pra quem prefere notação científica). Um fio de cabelo tem, em media, diâmetro de 100 micrômetros, 0,0001m, ou ainda 1 metro dividido por 10.000. 1 nanômetro é algo 100.000 vezes menor que um fio de cabelo! Ficou confuso? É que é difícil termos total consciência desses tamanhos nessa escala. Em nosso dia-a-dia estamos acostumados com distâncias e tamanhos da ordem de quilômetros, metros, centímetros, milímetros. São tamanhos que nosso cérebro consegue associar a objetos e experiências diárias. Sabemos que 200 metros é uma distância que pode ser facilmente percorrida a pé, mas que para se deslocar 200 km precisamos de um carro. Que 1 metro pode ser suficiente para uma mesa de escritório, mas pouco para uma mesa de jantar. Quando nos afastamos dessas dimensões “diárias” ou “padrões”, com as quais nosso cérebro está acostumado, precisamos de um pouco de abstração e novas referências para ter ideia de onde estamos localizados na escala das coisas. Se você quiser brincar um pouco com a ideia de escala, para entender o quão difícil é encontrar novas referências de tamanhos longe do que estamos acostumados no dia-a-dia, recomendo o site Escala do Universo.

Voltando aos nanômetros, as nanociências e nanotecnologia, são os ramos da ciência e engenharia que trabalham com a matéria nessa ordem de grandeza. Em nanotecnologia estamos trabalhando apenas um passo acima da escala atômica! Estamos fabricando, medindo, caracterizando “coisas” do tamanho de moléculas, as vezes alguns poucos átomos!

Um processador M3 tem seus componentes internos fabricados e um tamanho da ordem dos vírus e moléculas de alguns polímeros. Fonte: Autor

Isso nos dá uma dimensão do espetacular trabalho de engenharia que há por trás do desenho e fabricação de microchips e componentes eletrônicos. E não estou falando apenas do M3. Há uns bons anos a fabricação de processadores entrou nos domínios da nanotecnologia, produzindo transistores cada vez menores e mais densificados no interior de cada microchip. Desde pelo o início dos anos 2000 estamos usando microchips com dimensões menores que um milésimo de um fio de cabelo.

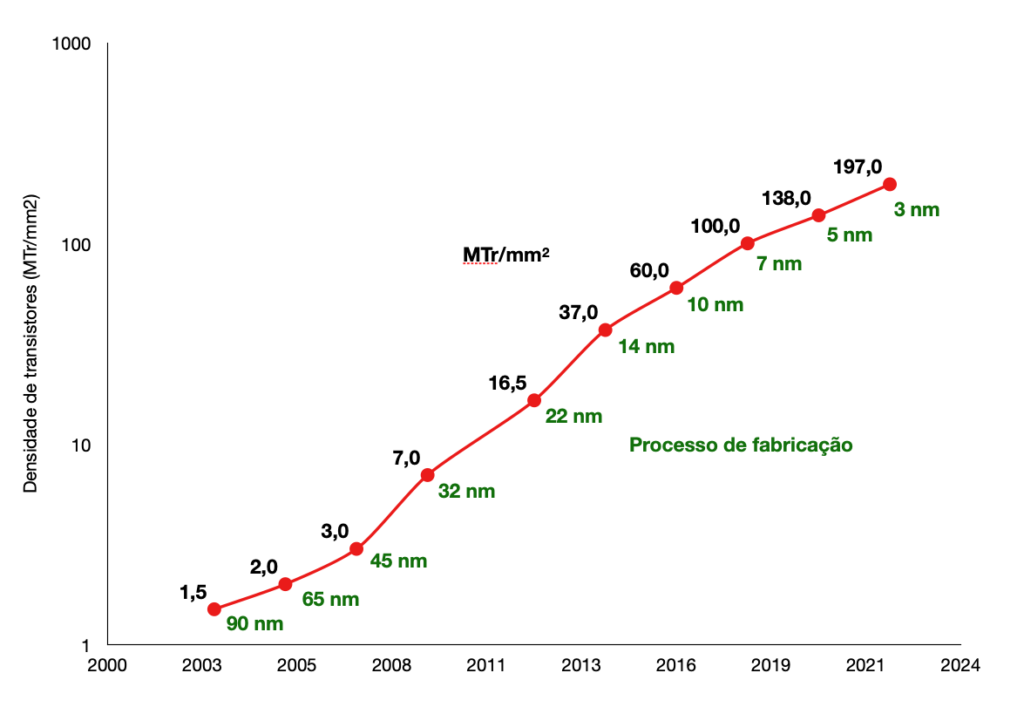

Diminuição do tamanho e consequente aumento na densidade de transistores no interior dos processadores. Fonte: Autor

A medida que o tamanho físico dos transistores diminui, aumenta a quantidade de transistores dentro de cada microchip. A densidade de transistores dentro de cada microchip hoje está na casa de impressionantes 200 milhões de transistores por milimetro quadrado! Uma conta simples mostra que, em um microchip de aproximadamente 11 mm de tamanho lateral, cabem os 25 bilhões de transistores que a Apple alega ter no M3.

Números como esse nos dão uma ideia do grau de complexidade envolvido na produção desses dispositivos e de quão avançada é a tecnologia de semicondutores. Além disso, nos fazem pensar como é possível fabricar essas coisas? Como podemos manipular a matéria a nível de algumas centenas de átomos? [Um átomo de silício tem aproximadamente 0,4 nm de diâmetro. Quando falamos de um transistor na casa de 50 nm de tamanho, estamos falando da distância de aproximadamente 125 átomos de silício alinhados!]. Essa ‘mágica’ acontece através da fotolitografia.

Escrevendo com luz

A fotolitografia é uma técnica que usa luz para “escrever” sobre uma superfície, criando padrões e desenhos específicos. Em um processo de fotolitografia, é utilizado algum material que seja fotossensível e que sofra alguma transformação quando exposto à luz. O material fotossensível protege a superfície da exposição à luz, e quando removido com o uso do solvente adequado expõe a superfície original. A fotolitografia foi criada por Nicéphore Niépce, um dos pioneiros na fotografia. Como utilizava a luz solar, a técnica ficou conhecida como heliografia. O material fotossensível usado por Nicéphore foi o “betume da Judéia” um tipo natural de asfalto. A fotografia mais antiga ainda existente do mundo, é a “vista da janela em Le Gras”, produzida por Nicéphore entre 1826 e 1827, na França.

A fotografia mais antiga do mundo, “Point de vue du gras” (vista da janela em Le Gras), produzida por Joseph Nicéphore Niépce através de técnica heliografia no século XIX. Mostra parte dos edifícios e a paisagem de uma janela da casa de Nicéphore. Fonte: https://en.wikipedia.org/wiki/View_from_the_Window_at_Le_Gras

Nicéphore usou uma câmera escura (dessas que a gente faz na escola para demonstrar a ideia de como funciona a fotografia) para projetar a paisagem de sua janela em uma placa de prata de aproximadamente 16 x 20 cm, recoberta com betume da Judéia. Quando exposto à luz solar, o betume da Judéia endurece, enquanto as partes que ficaram na sombra se mantêm solúveis e laváveis. Após a exposição a placa é lavada e a parte ainda solúvel do betume é removida, deixando registrado o padrão claro/escuro que forma a imagem.

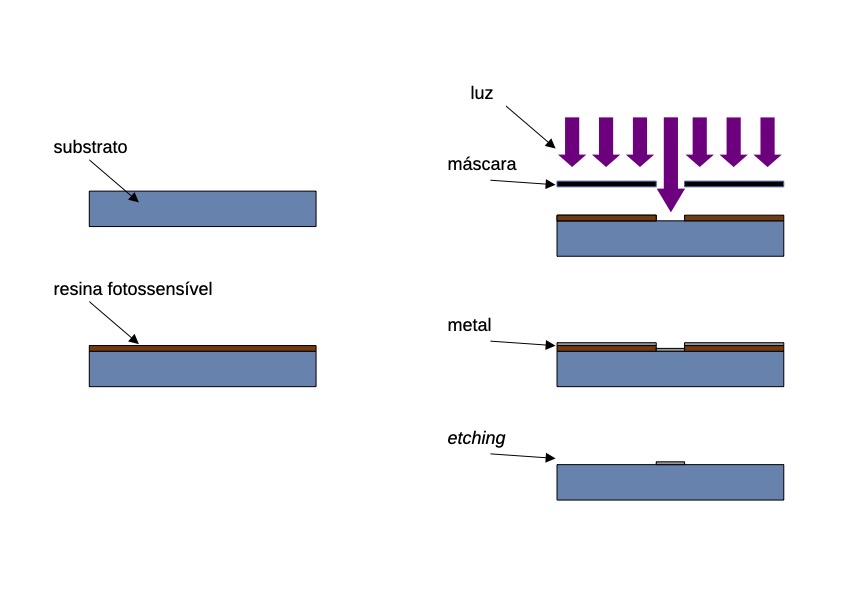

No processo moderno de fotolitografia, uma resina polimérica é utilizada como material fotossensível. A resina é sensibilizada rapidamente, em frações de segundo (ao contrário do processo original de Nicéphore que necessitava dezenas de horas de exposição ao sol). É um processo que envolve várias etapas, onde diferentes materiais são depositados sobre um substrato. No processo específico de componentes eletrônicos, filmes finos de metais e óxidos metálicos são depositados, camada por camada, com intrincados e diminutos padrões sobre a superfície de um substrato de silício. Os transistores que compõe um processador são formados diretamente sobre a superfície do silício, através de filmes finos metálicos de espessura nanométrica, depositados por fotolitografia.

De uma maneira bem simplificada, podemos ilustrar um processo de fotolitografia da seguinte maneira. Imagine que desejemos imprimir sobre um substrato alguma figura usando um determinado metal. Uma fina camada da resina fotossensível é depositada sobre o substrato. Logo, uma máscara com o recorte da figura ou padrão que queremos imprimir é posicionada sobre a superfície e iluminada com a luz usada no processo. Na parte vazada da máscara a luz remove a resina fotossensível, expondo o substrato, enquanto nas partes sob a “sombra” da máscara a resina segue protegendo a superfície. O próximo passo é depositar sobre toda a área uma fina camada do metal desejado. Por fim, uma limpeza química conhecida como etching remove a resina da superfície (junto do metal depositado sobre ela), deixando impresso a figura criada com a máscara. É realizando esse processo sucessivas vezes, com máscaras de padrões nanométricos, diferentes metais e óxidos, que os complexos desenhos que formam os transistores de um processador e todas as suas conexões são construídos.

Ilustração demonstrando de maneira extremamente simplificada o processo de fotolitografia. Fonte: Autor.

E é a luz utilizada no processo de fotolitografia que permite a miniaturização dos componentes, o desenho de figuras cada vez menores na superfície do substrato. Para escrever um cartaz em cartolina, como esses com preços em supermercados, você usa um lápis de ponta grossa (o popular “pincel atômico” ). Se vai assinar um documento em uma folha A4, muito provavelmente usará uma caneta com a ponta muito mais fina. Quanto mais fina a ferramenta de escrita, mais finos e precisos são os traços. No caso da fabricação de processadores, o que permitiu a miniaturização no processo foi o uso de luz com comprimentos de onda cada vez menores. A diminuição no comprimento de onda da luz nos permite “escrever” coisas cada vez menores na superfície.

O que chamamos de ‘luz’ é radiação eletromagnética, uma maneira de transportar energia pelo espaço, através de campos elétricos e magnéticos. Podemos classificar a luz em função de seu comprimento de onda, no que conhecemos como espectro eletromagnético.

Fonte: https://www.todoestudo.com.br/fisica/espectro-eletromagnetico

A única diferença entre a radiação de microondas que aquece os alimentos no forno da sua cozinha e os raios X que podem causar câncer, é a frequência ou o comprimento de onda. Essa parte colorida no espectro é o que chamamos de “luz visível”. De toda a radiação eletromagnética que chega a nossos olhos, somente a que está dentro desse pequeno intervalo de comprimentos de onda, aproximadamente entre 400 e 700 nm, é a que consegue sensibilizar células específicas localizadas nos nossos olhos e criar o que chamamos de visão. Toda a nossa visão, tudo o que conseguimos enxergar, depende da luz dessa pequena faixa do espectro eletromagnético. O restante do espectro eletromagnético interage de diferentes maneiras com nosso corpo e o meio em geral. Além disso, tem usos e aplicações diferentes. Todas as nossas comunicações (rádio, TV, satélites, celulares) estão dentro da região do rádio e microondas. Nossas redes wifi estão na frequência de GHz, microondas. Em medicina, as técnicas de diagnósticos por imagem utilizam massivamente radiação na região dos raios X. Em litografia começamos usando a luz solar, mas a tecnologia precisou migrar para comprimentos de onda cada vez menores para atingirmos o nível de miniaturização que temos hoje.

Os primeiros processos de fotolitografia nos anos 1970, que produziam componentes da ordem de micrômetros (1 metro dividido por 1 milhão!), usavam luz próxima do infravermelho, com comprimentos de onda da ordem de micrômetros. O grande salto na miniaturização, e consequentemente no adensamento de componentes no interior dos microchips/processadores, ocorreu a partir dos anos 1990, quando saltamos do infravermelho para o outro extremo do espectro visível, com a fotolitografia de ultravioleta profundo (DUP – deep ultraviolet). A fotolitografia DUP utiliza luz no comprimento de onda de 193 nm. Ela foi utilizada até meados de 2018, na produção de microchips com tecnologia de 7 nm.

O fim da Lei de Moore, ou não.

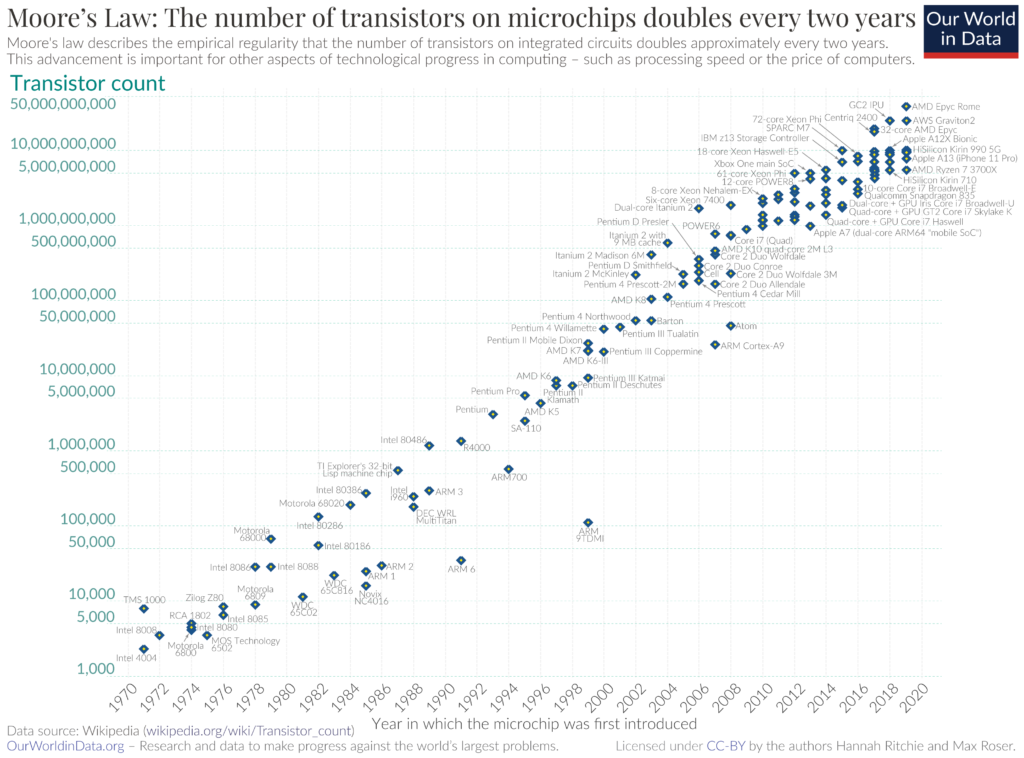

Em 1965, Gordon Moore trabalhava como diretor de pesquisa e desenvolvimento na Fairchild Semiconductor, uma das empresas pioneiras a se instalar na região que viria a ser conhecida como o Vale do Silício. Em uma entrevista à Electronics Magazine, Moore foi perguntado sobre como ele pensava que iria evoluir pelos próximos 10 anos a industria dos circuitos integrados (CI), que haviam sido inventados poucos anos antes. Moore tinha observado que naqueles primeiros anos da industria de semicondutores, a quantidade de componentes (diodos, transistores, capacitores) no interior dos circuitos integrados vinha dobrando a cada ano. Ele então previu que essa tendência continuaria por pelo menos 10 anos. O que se mostrou acertado. Em 1975, Moore revisou sua previsão, estimando que a quantidade de componentes dobraria no interior de cada CI a cada 2 anos. E ele acertou de novo, com essa relação se mantendo válida e vigente por décadas, até pelo menos 2010. Porém, o próprio Moore tinha consciência de que sua lei não poderia durar pra sempre, e em algum momento a miniaturização dos microchips encontraria um limite. Em uma entrevista de 2005 ele previu que a lei teria mais 10 ou 20 anos de vigência. Vale observar que a lei de Moore não é uma lei básica da natureza, não é uma lei da física. É algo empírico, baseado na experiência de Moore e na constatação de como a fabricação dos circuitos integrados vinha evoluindo. Foi um “chute”, mas um chute fortemente embasado no conhecimento de Moore das técnicas de fabricação e de sua experiência de mercado.

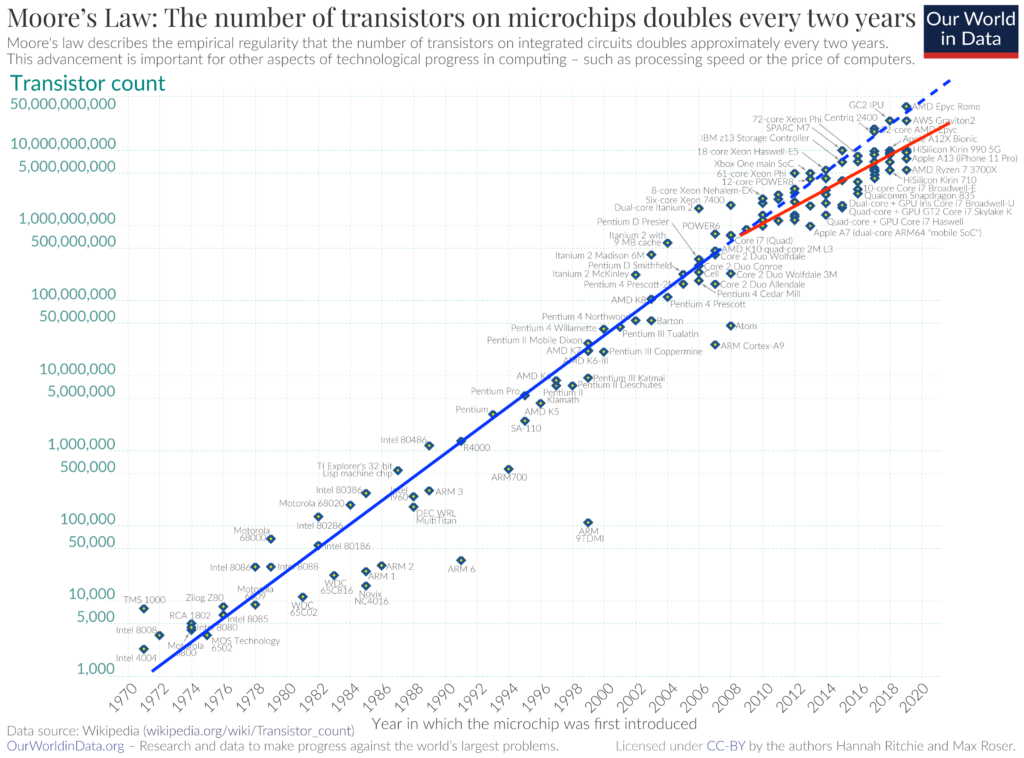

Este gráfico mostra a quantidade total de transistores estimada dentro de cada microchip. Não confundir com o gráfico anterior que mostrava a densidade de transistores por mm2. Fonte imagem: https://upload.wikimedia.org/wikipedia/commons/0/00/Moore’s_Law_Transistor_Count_1970-2020.png

A partir de aproximadamente 2010, o ritmo de miniaturização e adensamento de transistores no interior dos processadores começou a diminuir, avançando em um ritmo menor do que o previsto pela Lei de Moore. Se traçarmos a “linha ideal” entre os pontos do gráfico anterior, vemos que a partir de 2010 há um desvio, uma queda no ritmo de miniaturização dos microchips.

Um ajuste linear aproximado nos permite visualizar como, a partir de 2010, há uma diminuição no ritmo de adensamento/miniaturização dos microchips, deixando de seguir o crescimento previsto pela Lei de Moore. Fonte da imagem: https://upload.wikimedia.org/wikipedia/commons/0/00/Moore’s_Law_Transistor_Count_1970-2020.png Adaptado pelo autor.

Para alguns, era o início do fim da Lei de Moore. Depois de décadas prevendo o avanço da industria de semicondutores, a Lei de Moore parecia finalmente estar chegando ao seu limite. Quem usou algum Mac Intel de 2010 a 2020 notou uma aparente estagnação na performance. Não havia grande diferenças de performance a cada nova geração de Macs. As melhoras de performance foram mais incrementais, e e tornavam mais visíveis quando comparados processadores com 2 ou 3 gerações de diferença [Ao contrário dos anos 90, onde a diferença de performance entre um Pentium 100 e um 133 por exemplo era paupável]. Muitos acusavam/acusam a Intel de “se acomodar”, deixar de inovar. Sejamos justos, não era essa a causa. O fato é que a tecnologia de produção de processadores, a fotolitografia de ultravioleta profundo estava no seu limite. Para voltar a avançar significativamente, e manter a Lei de Moore vigente, era preciso uma nova tecnologia. E ela se tornou viável comercialmente em 2022.

Fotolitografia do Ultravioleta Extremo

No meu artigo sobre Vidro aqui no Macmagazine, comentei que o Gorilla Glass começou a ser desenvolvido pela Corning em 1960 e só foi ao mercado com o iPhone em 2007. A ideia de que cientistas tem “lampejos mágicos”, com momentos “Eureka”, onde criam coisas maravilhosas quase que instantaneamente, de uma hora para outra, é apenas uma visão romântica e fantasiosa de como a ciência e a tecnologia funcionam. Desenvolver uma tecnologia custa tempo, esforço, dedicação e dinheiro, muito dinheiro. As pesquisas para desenvolver a tecnologia que salvaria a Lei de Moore começaram em 1990! A Lei de Moore se manteve vigente por décadas devido ao esforço no desenvolvimento de novas tecnologias que permitisse a densificação e miniaturização cada vez maiores de transistores no interior dos microchips. Podemos pensar a Lei de Moore como uma “força” que empurrou toda a industria dos semicondutores no sentido da miniaturização dos componentes. Mas todos sabiam que isso tinha um limite. Era uma questão de tempo.

O próximo passo para a miniaturização, depois do ultravioleta profundo (193 nm), seria o ultravioleta extremo (UV-extremo, ou EUV em inglês), uma luz com comprimento de onda de apenas 13 nm. Mas o ultravioleta extremo apresentava dificuldades enormes para ser utilizado, de maneira que muitos consideraram impossível a fotolitografia por UV-extremo. Lembra mais acima, onde eu disse que a luz de diferentes comprimentos de onda interage de maneiras diferentes com nosso corpo o mundo em geral? Pois bem, o UV-extremo é absorvido pelo ar e pelo vidro. Isso significa que uma máquina de litografia que use UV-extremo não pode usar lentes de vidro para alinhar e direcionar os feixes de luz no processo de litografia, tendo então que usar espelhos. E todo o interior da máquina precisa estar em alto vácuo. Além disso, a radiação de UV-extremo não é facilmente produzida, e seria preciso desenvolver uma fonte estável de radiação UV-extremo. Para superar essas dificuldades, o governo dos EUA formou, em 1990, um consórcio de laboratórios de diferentes universidades e centros de pesquisa. O consórcio foi financiado pelo Estado norte americano para desenvolver a tecnologia que tornasse possível a fotolitografia por UV-extremo. Em 2001 a ASML, uma então relativamente pequena empresa holandesa de pouco mais de 300 funcionários, adquiriu os direitos de explorar a tecnologia desenvolvida pelo consórcio americano, e fabricar uma máquina comercial para fotolitografia de UV-extremo. A ASML se uniu à ZEISS e à Oxford Instruments, para produzir a máquina que salvaria a Lei de Moore. O primeiro protótipo surgiu em 2006, e levava 23 horas para produzir um wafer de silício (um disco com 30 cm de diâmetro). Em 2018, quando a máquina se tornou comercial, era capaz de produzir 200 wafers por hora! Foram 17 anos de desenvolvimento, e um investimento da ordem de 9 bilhões de dólares. Cada máquina de UV-extremo produzida pela ASML tem o tamanho de um ônibus, custa em torno de 200 milhões de dólares e precisa ser transportada desmontada em 4 Boeings 747 para ser entregue a cada cliente. A ASML é hoje a única empresa do mundo a fabricar máquinas para a fotolitografia de UV-extremo. Em 2021, a empresa teve lucro de 18 bilhões de Euros! Quem estiver interessado em saber mais detalhes técnicos da máquina e de todo o processo de desenvolvimento feito pela ASML, essa reportagem do MIT Technology Review é sensacional.

Parte da máquina de fotolitografia de UV-extremo em processo de fabricação na ASML. Fonte: https://www.technologyreview.com/2021/10/27/1037118/moores-law-computer-chips/

Os limites da física

Se você chegou até aqui leitor, você é um guerreiro! Obrigado pelo empenho e dedicação, espero que tenha gostado e prometo ser breve na finalização deste texto. A fotolitografia de UV-extremo deve manter a Lei de Moore válida por mais alguns anos. A ASML está trabalhando na próxima versão da sua máquina, o que a empresa chama de fotolitografia de UV-extremo de alta abertura numérica (high-NA EUV), que deverá permitir a fabricação de componentes por debaixo dos 10 nanômetros (agora estamos falando da dimensão física real dos componentes no interior de cada microchip) e manter a Lei de Moore relevante até, pelo menos, meados de 2030. O que vem além disso? Ainda não sabemos. O fato é que estamos chegando próximo dos limites impostos pela física. Nessas dimensões, de alguns poucos nanômetros, fenômenos quânticos que não observamos na escala do dia-a-dia começam a aparecer. As propriedades da matéria mudam quando nos aproximamos da escala atômica. Elétrons se comportam de maneira diferente, de modo que manter o fluxo de cargas elétricas que fazem um microchip funcionar torna-se um desafio. Estamos chegando próximo dos limites impostos pela natureza, e a industria de semicondutores terá que se reinventar. Que venha logo a computação quântica!